Google Search là một công cụ hoàn toàn tự động, chuyên cung cấp những kết quả phù hợp và hữu ích nhất cho người dùng khi tìm kiếm trên Google.

Kể từ năm 1998, Google đã liên tục tinh chỉnh thuật toán của mình, chạy hàng triệu thử nghiệm và học hỏi từ dữ liệu người dùng, thực hiện hàng nghìn bản cập nhật mỗi năm.

Vậy Google Search hoạt động như thế nào? Google dựa vào đâu để đánh giá chất lượng và xếp hạng cho 1 website? Tất cả sẽ được mình, Nguyễn Thanh Trường – Founder & CEO của SEO Center chia sẻ chi tiết trong bài viết dưới đây.

Mục tiêu của bài viết này là giúp bạn hiểu rõ hơn về nguyên tắc hoạt động và xếp hạng của Google, từ đó có thể tối ưu cho website của mình được tốt hơn, giúp Google đọc hiểu nội dung trên website dễ hơn và đạt được thứ hạng cao hơn.

Nội dung chính của bài viết:

- Google Search hoạt động qua ba giai đoạn cốt lõi: thu thập dữ liệu (Crawling) để khám phá, lập chỉ mục (Indexing) để hiểu và lưu trữ, và xếp hạng (Ranking) để hiển thị các kết quả phù hợp nhất cho người dùng.

- Google không ngừng phát triển và tinh chỉnh các thuật toán thông qua hàng triệu thử nghiệm và học hỏi liên tục từ dữ liệu tương tác của người dùng cùng các hệ thống học sâu (như RankBrain, BERT) để cải thiện chất lượng tìm kiếm.

- Để đạt thứ hạng cao, Google xem xét hàng trăm yếu tố như chất lượng và sự liên quan của nội dung (E-E-A-T), backlink, tốc độ tải trang, tính thân thiện với thiết bị di động, và khả năng đáp ứng đúng ý định tìm kiếm của người dùng.

- Google không chấp nhận bất kỳ khoản thanh toán nào để xếp hạng cao hơn trong kết quả tìm kiếm tự nhiên; vị trí trên SERP hoàn toàn phụ thuộc vào giá trị thực sự mà website mang lại cho người dùng.

- Mục tiêu cuối cùng của Google là cung cấp kết quả hữu ích nhất, do đó, việc tối ưu website cần tập trung vào việc tạo ra nội dung chất lượng cao, độc đáo, và mang lại trải nghiệm người dùng vượt trội.

Nội dung bài học

Tổng quan về Google Search

Google Search là một công cụ tìm kiếm hoàn toàn tự động. Điều này có nghĩa là Google không cần con người phải tự tay “nhập” từng trang, từng website hay sắp xếp chúng. Thay vào đó, Google sử dụng các chương trình máy tính tự động đặc biệt gọi là trình thu thập dữ liệu (web crawlers, bots, hay spiders).

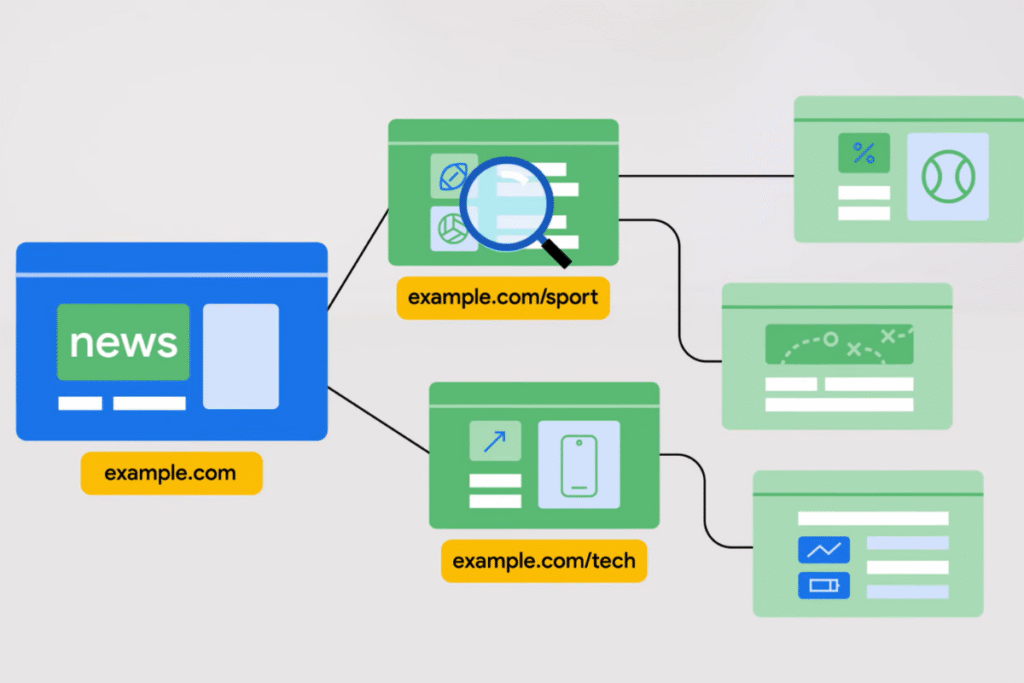

Nhiệm vụ của những trình thu thập dữ liệu này là khám phá (crawl) các website và thêm các trang chungs vào chỉ mục của Google. Chỉ mục của Google có thể hình dung như một hệ thống “mục lục” hay “danh mục” khổng lồ, được lưu trữ trên hàng nghìn máy tính, ghi lại thông tin chi tiết về nội dung của hàng trăm tỷ trang mà nó đã tìm thấy.

Mục tiêu cuối cùng của toàn bộ quá trình này là khi bạn gõ một câu hỏi hay từ khóa vào ô tìm kiếm, Google sẽ cung cấp những kết quả phù hợp và hữu ích nhất cho bạn.

Google không phải là một hệ thống tĩnh mà nó liên tục phát triển và cải tiến. Từ khi ra mắt vào năm 1998, Google đã:

- Liên tục tinh chỉnh các thuật toán tìm kiếm của mình. Các thuật toán này là những bộ quy tắc phức tạp giúp Google xác định trang nào nên được hiển thị và ở vị trí nào.

- Thực hiện hàng triệu thử nghiệm mỗi năm. Những thử nghiệm này giúp Google đánh giá xem những thay đổi tiềm năng có thực sự cải thiện chất lượng kết quả tìm kiếm cho người dùng hay không.

- Học hỏi từ dữ liệu người dùng. Google phân tích cách người dùng tương tác với kết quả tìm kiếm (ví dụ: họ nhấp vào những liên kết nào, họ dành bao lâu trên trang, v.v.) để hiểu rõ hơn nhu cầu của họ và cải thiện chất lượng tìm kiếm.

- Thực hiện hàng nghìn bản cập nhật mỗi năm. Những cập nhật này có thể là những thay đổi nhỏ hoặc các bản cập nhật lớn hơn, nhằm mục đích nâng cao độ chính xác, độ liên quan của kết quả và chống lại các thủ thuật spam trên các website.

Một điểm cực kỳ quan trọng và là nền tảng hoạt động của Google là: Google không chấp nhận thanh toán để thu thập dữ liệu một trang web thường xuyên hơn hoặc để xếp hạng trang đó cao hơn trong các kết quả tìm kiếm tự nhiên.

Điều này có nghĩa là, bạn không thể “mua” vị trí cao trong kết quả tìm kiếm tự nhiên (còn gọi là kết quả tìm kiếm hữu cơ) của Google. Google thiết kế hệ thống của mình để đảm bảo rằng các kết quả mà người dùng thấy là hoàn toàn khách quan, dựa trên các yếu tố như chất lượng, độ liên quan, và sự hữu ích của trang web đối với truy vấn của người dùng.

Tuy nhiên, Google có chấp nhận thanh toán cho các kết quả tìm kiếm trả phí (quảng cáo), thường xuất hiện ở đầu trang kết quả tìm kiếm hoặc xen kẽ giữa các kết quả tự nhiên. Những kết quả này luôn được đánh dấu rõ ràng là “Quảng cáo” (Ad) để người dùng dễ dàng phân biệt. Việc này là cách Google tạo ra doanh thu từ dịch vụ của mình.

Ba giai đoạn cốt lõi của Google Search

Google Tìm kiếm hoạt động theo ba giai đoạn chính là:

- Thu thập dữ liệu (Crawling)

- Lập chỉ mục (Indexing)

- Xếp hạng (Ranking)

Giai đoạn 1: Thu thập dữ liệu (Crawling)

Thu thập dữ liệu hay Crawling là quá trình Google sử dụng các chương trình tự động đặc biệt, được gọi là trình thu thập dữ liệu (crawlers, bots, spiders), để khám phá và tải xuống nội dung của các trang trên internet. Bạn có thể hình dung chúng như những “con nhện” điện tử không ngừng bò khắp các website, đọc và ghi nhớ thông tin.

Cách thức Google khám phá URL

Google liên tục tìm kiếm các trang web mới hoặc các trang đã có sự thay đổi. Có ba cách chính để Google tìm thấy các địa chỉ web (hay URL) mới:

- Từ các liên kết ngược (backlink): Đây là cách phổ biến nhất. Google tìm thấy các trang mới bằng cách theo dõi các liên kết từ các trang web mà nó đã biết và đã thu thập dữ liệu trước đó.

- Từ sơ đồ trang web (sitemaps): Các chủ sở hữu trang web có thể tạo một tệp đặc biệt gọi là sơ đồ trang web, trong đó liệt kê tất cả các trang quan trọng trên website của họ. Tệp này giống như một “bản đồ kho báu” giúp Googlebot dễ dàng tìm đến những nội dung chính mà không bỏ sót. Sơ đồ trang web không bắt buộc nhưng rất hữu ích.

- Từ việc gửi URL thủ công: Chủ website sẽ tự mình yêu cầu Google thu thập dữ liệu các URL riêng lẻ thông qua công cụ Google Search Console.

Google Bot

Googlebot là tên gọi của trình thu thập dữ liệu chính của Google. Googlebot không “ngẫu nhiên” ghé thăm các trang. Nó sử dụng các thuật toán để quyết định trang nào cần thu thập dữ liệu, tần suất và số lượng trang cần tải từ mỗi trang và mỗi website.

Googlebot được lập trình để không thu thập dữ liệu quá nhanh nhằm tránh làm quá tải trang web của bạn. Nó sẽ dựa trên phản hồi của trang web (ví dụ: nếu trang bị lỗi 500 – lỗi máy chủ) để điều chỉnh tốc độ. Tốc độ thu thập dữ liệu khác nhau tùy mỗi trang.

Googlebot chỉ đọc được thông tin từ các URL có thể truy cập công khai. Nếu nội dung của bạn yêu cầu đăng nhập, ví dụ như nội dung trong một diễn đàn riêng tư hoặc email của bạn, Googlebot sẽ không thể thu thập được.

Kết xuất trang (Rendering)

Sau khi tải xuống dữ liệu một trang hay còn gọi là quá trình gọi là tìm nạp, Google sẽ kết xuất (render) trang đó bằng một phiên bản Chrome gần đây, giống hệt cách trình duyệt web của bạn hiển thị trang.

Điều này rất quan trọng vì nhiều trang web hiện đại sử dụng JavaScript để hiển thị nội dung động. Nếu không kết xuất, Google sẽ không nhìn thấy được nội dung đó và sẽ bỏ lỡ thông tin quan trọng trên trang của bạn.

Các yếu tố ngăn cản Bot thu thập dữ liệu

Có một số lý do khiến Googlebot không thể thu thập dữ liệu trang của bạn:

- Các quy tắc trong tệp robots.txt do chủ sở hữu trang web đặt ra, chỉ dẫn Googlebot không ghé thăm một số phần của trang web.

- Lỗi máy chủ (ví dụ: HTTP 500) hoặc các vấn đề mạng khiến trang web không phản hồi.

- Nội dung không thể truy cập công khai (yêu cầu đăng nhập).

- Chất lượng nội dung không đạt ngưỡng yêu cầu của Google.

Ngân sách thu thập dữ liệu (Crawl Budget)

Đây là lượng thời gian hoặc tài nguyên mà trình thu thập dữ liệu dành cho một trang web trong một khoảng thời gian nhất định. Ngân sách này bị ảnh hưởng bởi:

- Nhu cầu thu thập dữ liệu: Trang web của bạn phổ biến đến mức nào và nội dung có thường xuyên được cập nhật không.

- Khả năng thu thập dữ liệu: Trang web của bạn phản hồi các yêu cầu của Googlebot nhanh đến mức nào.

Giai đoạn 2: Lập chỉ mục (Indexing)

Sau khi một trang được thu thập dữ liệu, Google sẽ cố gắng hiểu nội dung của trang đó và lưu trữ thông tin này vào chỉ mục của mình. Chỉ mục này giống như một thư viện khổng lồ của Google, được lưu trữ trên hàng nghìn máy tính, chứa tất cả các thông tin đã được phân loại về các trang và các website.

Quá trình phân tích

Để hiểu nội dung trang, Google thực hiện các bước phân tích sau:

- Xử lý và phân tích nội dung văn bản: Google đọc và hiểu các từ ngữ trên trang.

- Thuộc tính thẻ nội dung chính: Google xem xét các yếu tố như thẻ <title> (tiêu đề của trang), thuộc tính alt của hình ảnh (văn bản mô tả hình ảnh), hình ảnh, video và các tín hiệu tính toán khác.

- Xác định chủ đề và từ khóa: Dựa trên quá trình phân tích, Google xác định chủ đề chính của trang và các từ khóa liên quan.

Xử lý HTML và lỗi ngữ nghĩa

Google phân tích cấu trúc HTML của trang web và khắc phục bất kỳ vấn đề ngữ nghĩa nào để đảm bảo các thẻ HTML được đặt đúng vị trí và có ý nghĩa.

Nếu HTML bị lỗi, Google có thể không hiểu được toàn bộ nội dung.

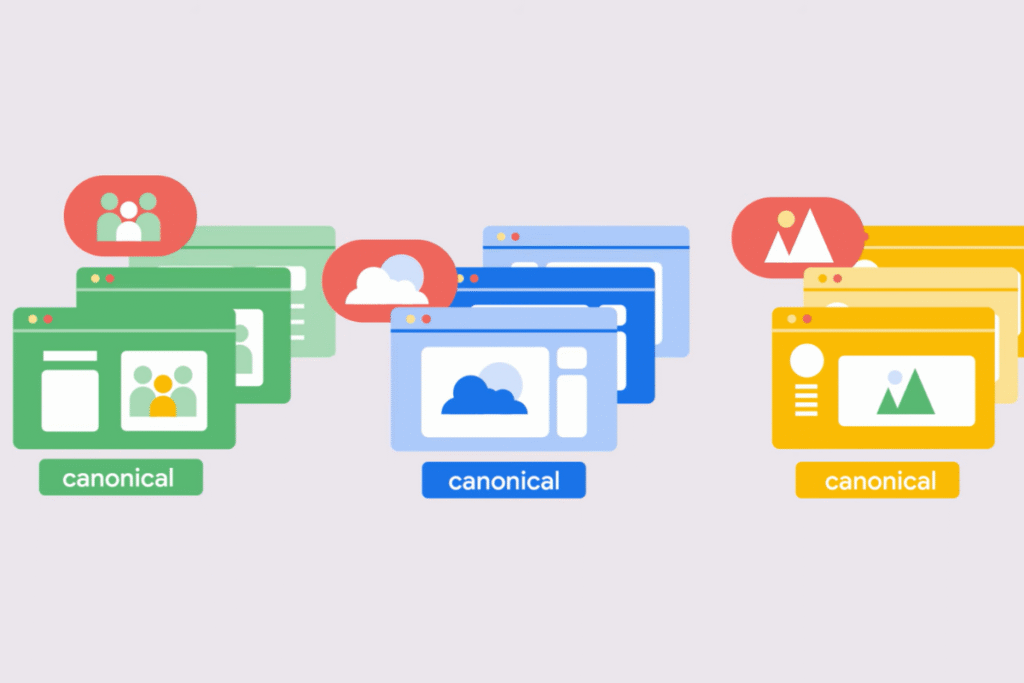

Xác định phiên bản chính tắc

Trong 1 website thường sẽ có các nội dung trùng lặp hoặc rất giống nhau. Google cần xác định liệu một trang có phải là bản sao của trang khác hay không. Các bước Google xác định phiên bản chính tắc như sau:

- Bước 1: Nhóm các trang tương tự (clustering): Các trang có nội dung tương tự sẽ được Google nhóm lại với nhau.

- Bước 2: Chọn phiên bản “chính tắc”: Trong nhóm đó, Google sẽ chọn ra một phiên bản được coi là đại diện tốt nhất cho nhóm đó để hiển thị trong kết quả tìm kiếm. Các phiên bản khác được coi là “thay thế”.

- Bước 3: Tín hiệu để chọn chính tắc: Google sử dụng nhiều tín hiệu để chọn phiên bản chính tắc, bao gồm cả gợi ý từ website (ví dụ: sử dụng thẻ rel=”canonical” trong HTML) và mức độ quan trọng của trang trên internet.

Mặc dù nội dung trùng lặp không phải là vi phạm chính sách spam, nhưng nó có thể gây trải nghiệm người dùng kém và lãng phí tài nguyên thu thập dữ liệu của Google.

Quyết định lập chỉ mục (Index Selection)

Google quyết định có lập chỉ mục cho trang hay không, chủ yếu dựa trên chất lượng của trang và các tín hiệu đã thu thập.

Google không lập chỉ mục mọi trang mà nó thu thập dữ liệu. Vì mục tiêu của Google là chỉ muốn hiển thị các trang chất lượng cao trong kết quả tìm kiếm.

Một trang sẽ không được lập chỉ mục nếu:

- Chất lượng nội dung thấp hoặc vi phạm chính sách nội dung của Google.

- Trang trả về lỗi mã trạng thái HTTP (ví dụ: lỗi 4xx hoặc 5xx).

- Thiết kế trang gây khó khăn cho việc lập chỉ mục.

- Chủ sở hữu trang đã yêu cầu không lập chỉ mục (thông qua thẻ noindex).

Cách được lập chỉ mục: Bạn có thể chờ Googlebot tự động khám phá và lập chỉ mục trang của mình, hoặc bạn có thể gửi trang để lập chỉ mục thông qua Google Search Console. Quá trình này có thể mất vài ngày hoặc thậm chí vài tuần.

Giai đoạn 3: Xếp hạng (Ranking)

Giai đoạn này Google sẽ xác định thứ tự các kết quả xuất hiện để phản hồi truy vấn tìm kiếm của người dùng. Khi bạn gõ một từ khóa vào ô tìm kiếm, Google sẽ tìm kiếm các trang phù hợp từ chỉ mục của mình và trả về những kết quả mà nó cho là chất lượng cao nhất và phù hợp nhất.

Thuật toán tìm kiếm

Google sử dụng hàng trăm thuật toán và mô hình học máy khác nhau như Google Panda, Google Penguin, Google RankBrain, Google HummingBird,…. để xếp hạng kết quả trên SERPs.

Các thuật toán này sẽ lọc chỉ mục khổng lồ để tìm ra các tài liệu liên quan nhất.

Quá trình lọc dữ liệu

Từ hàng chục nghìn tài liệu tiềm năng có thể khớp với truy vấn của bạn, các thuật toán sẽ sử dụng một loạt các tín hiệu, được gọi là yếu tố xếp hạng, để giảm xuống chỉ còn vài trăm tài liệu phù hợp nhất.

Sau đó, các hệ thống học máy sẽ tiếp tục tinh chỉnh thứ tự của các tài liệu này để cho ra được các thứ hạng 1, 2, 3, 4, 5,…. Trên SERP

Các yếu tố xếp hạng chính của Google

Google sử dụng rất nhiều loại tín hiệu để quyết định thứ hạng. Dưới đây là một số yếu tố quan trọng nhất mà bạn phải nắm:

- Bản thân tài liệu / Từ khóa: Các từ ngữ trên trang là tín hiệu quan trọng nhất để tìm ra tài liệu phù hợp. Các từ khóa này thể hiện chủ đề chính của trang. Ví dụ: Nếu bạn tìm “công thức phở cuốn”, Google sẽ ưu tiên những trang có chứa các từ “công thức”, “phở cuốn” và các từ liên quan trong nội dung, tiêu đề, hoặc mô tả.

- Backlink: Các liên kết từ một trang trên website khác trỏ đến trang của bạn hoạt động như những “phiếu bầu tin cậy”. Chất lượng của các liên kết này quan trọng hơn số lượng. Google sử dụng một thuật toán gọi là PageRank để đánh giá mức độ quan trọng và đáng tin cậy của các trang web dựa trên các liên kết này.

- Tính thời sự: Các trang được xuất bản gần đây thường có thông tin chính xác hơn, đặc biệt đối với các truy vấn yêu cầu thông tin mới (ví dụ: tin tức, sự kiện).

- Chất lượng trang (Page Quality / E-E-A-T): Google ưu tiên nội dung thể hiện Kinh nghiệm (Experience), Chuyên môn (Expertise), Tính xác thực (Authoritativeness) và Độ tin cậy (Trustworthiness – E-E-A-T). Google nói rằng, E-E-A-T không phải là yếu tố xếp hạng trực tiếp mà là khuôn khổ để đánh giá chất lượng.

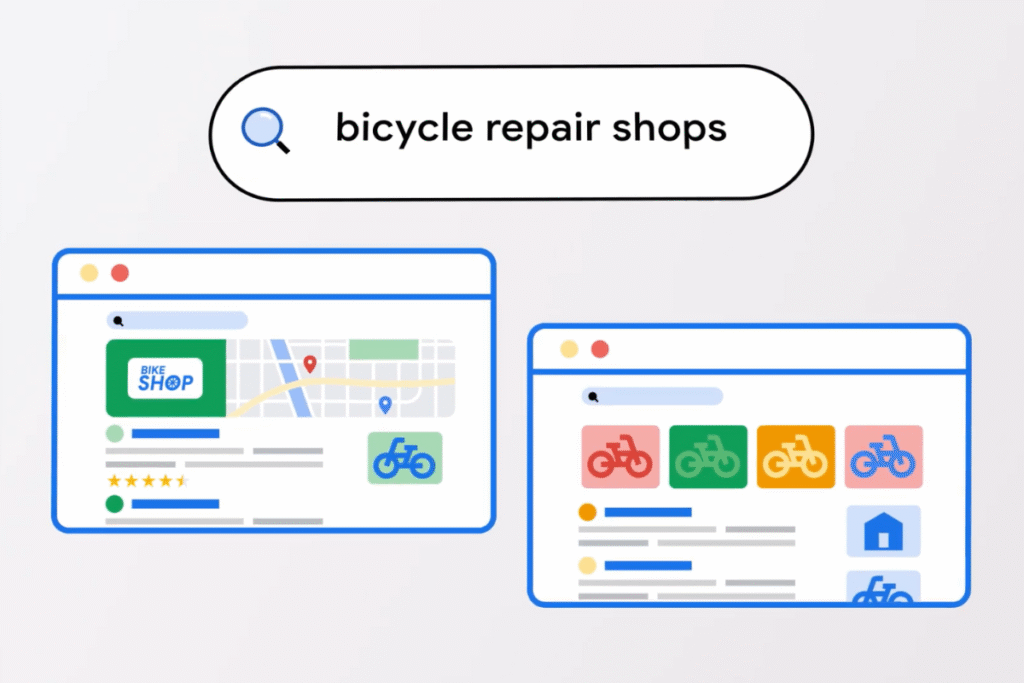

- Vị trí địa lý: Vị trí địa lý của người tìm kiếm ảnh hưởng đến kết quả, đặc biệt đối với các tìm kiếm có ý định địa phương (ví dụ: “quán cafe gần đây”). Ví dụ: Nếu bạn tìm “tiệm bánh mì”, kết quả ở Hà Nội sẽ khác với kết quả ở TP. Hồ Chí Minh, kết quả ở quận 12 sẽ khác với kết quả ở quận Gò Vấp.

- Tăng cường điều hướng (Navboost) / Glue: Đây là một trong những tín hiệu quan trọng nhất của Google, được đào tạo dựa trên dữ liệu tương tác của người dùng (như lượt nhấp chuột, di chuột, cuộn trang) và ghi nhớ các lượt nhấp vào truy vấn trong quá khứ (ví dụ: 16 tháng qua). Navboost giúp Google lọc từ nhiều tài liệu xuống còn ít tài liệu hơn. Nó hoạt động sau khi người dùng nhấp vào một tài liệu/trang. Ví dụ: Nếu nhiều người dùng ở Việt Nam tìm kiếm “cách làm bánh tét” và thường xuyên nhấp vào một trang web cụ thể về công thức bánh tét, Navboost sẽ ghi nhớ hành vi này và có thể giúp trang đó được xếp hạng cao hơn trong các tìm kiếm tương lai.

- Tốc độ trang (Page Speed): Các trang tải chậm có thể ảnh hưởng tiêu cực đến thứ hạng, đặc biệt là các trang chậm nhất.

- Thân thiện với thiết bị di động (Mobile-friendliness): Yếu tố này trở nên quan trọng kể từ khi Google chuyển sang lập chỉ mục ưu tiên thiết bị di động vào năm 2019.

- Trải nghiệm người dùng (User Experience): Các trang tải nhanh, dễ dùng trên di động, không có quảng cáo gây phiền nhiễu, có điều hướng rõ ràng và sử dụng kết nối bảo mật (HTTPS) được ưu tiên.

- Ý định tìm kiếm (Search Intent): Google cố gắng hiểu ý định đằng sau mỗi tìm kiếm (muốn tìm thông tin, mua sắm, giao dịch hay tìm một trang web cụ thể) và hiển thị nội dung phù hợp. Ví dụ: Nếu bạn tìm “mua điện thoại Samsung”, Google sẽ hiển thị các trang bán hàng, cửa hàng điện thoại. Còn nếu bạn tìm “đánh giá điện thoại Samsung”, Google sẽ hiển thị các bài viết, video review.

- Lịch sử tìm kiếm của người dùng (User History): Google cá nhân hóa kết quả dựa trên các tìm kiếm và trang đã truy cập trước đây của bạn.

- Topical Authority: Google tin tưởng các trang web thể hiện chuyên môn sâu trong lĩnh vực của họ, thường được xây dựng bằng cách tạo các cụm chủ đề (topic clusters).

Lưu ý quan trọng: Google không chấp nhận thanh toán để thu thập dữ liệu một trang hay 1 website thường xuyên hơn hoặc để xếp hạng cao hơn. Tất cả các quy trình đều tự động và dựa trên chất lượng, mức độ liên quan.

Hệ thống học sâu và Dữ liệu người dùng trong xếp hạng

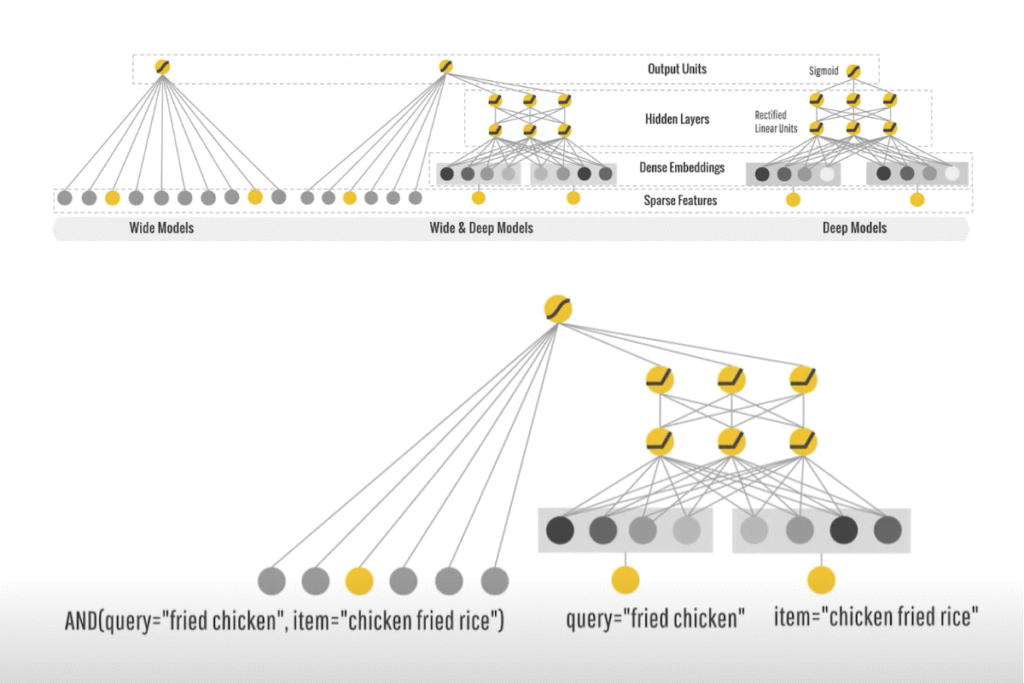

Hệ thống học sâu (Deep Learning)

Học sâu là một nhánh của trí tuệ nhân tạo, cho phép máy tính học hỏi từ một lượng lớn dữ liệu bằng cách sử dụng các mạng thần kinh nhân tạo phức tạp. Google bắt đầu áp dụng công nghệ này vào năm 2015.

Mục tiêu chính của việc sử dụng học sâu là để điều chỉnh điểm số của các tài liệu, tức là các trang, và tham gia vào quá trình truy xuất thông tin. Tuy nhiên, Google không giao phó hoàn toàn mọi thứ cho các hệ thống học sâu này, vì điều đó có thể gây rủi ro về mặt kiểm soát kết quả.

Hãy hình dung thế này: Thay vì chỉ dựa vào một danh sách các luật lệ cố định, Google dạy cho hệ thống của mình cách “tự học” để nhận diện các mẫu và đưa ra quyết định thông minh hơn, tương tự như việc một người học hỏi kinh nghiệm để giỏi hơn trong công việc.

Dưới đây là một số mô hình học sâu quan trọng mà Google sử dụng:

RankBrain

Sau khi Google đã tìm ra hàng chục nghìn tài liệu tiềm năng cho một truy vấn, RankBrain sẽ xem xét 20-30 tài liệu hàng đầu và điều chỉnh điểm số ban đầu của chúng. Nó không được chạy trên hàng trăm hay hàng nghìn kết quả vì quá tốn kém.

Cách học: RankBrain được “huấn luyện” dựa trên các truy vấn và dữ liệu nhấp chuột của người dùng trong vòng 13 tháng qua (trước năm 2017 là 18 tháng).

Nó cũng được tinh chỉnh dựa trên dữ liệu đánh giá IS (Information Satisfaction – Mức độ hài lòng thông tin), một thước đo chất lượng tìm kiếm hàng đầu của Google từ đánh giá của con người. RankBrain giúp Google hiểu được nhu cầu dài hạn của người dùng.

Ví dụ: Khi bạn tìm kiếm “cách làm món xôi gấc truyền thống”, Google có thể có hàng nghìn công thức. RankBrain sẽ nhìn vào những công thức top đầu, và dựa trên việc trước đây người dùng tìm “xôi gấc” thường thích những trang có video hướng dẫn hay công thức chi tiết, nó sẽ điều chỉnh thứ hạng để những trang đó được ưu tiên hơn, ngay cả khi bạn không ghi rõ “có video” trong truy vấn của mình.

DeepRank

DeepRank là tên gọi của BERT khi thuật toán BERT được sử dụng để xếp hạng các trang. Nó kế thừa và tận dụng nhiều khả năng hơn từ RankBrain.

Cách học: Tương tự RankBrain, DeepRank được huấn luyện dựa trên dữ liệu người dùng và tinh chỉnh dựa trên dữ liệu xếp hạng IS.

Khả năng: DeepRank có khả năng hiểu ngôn ngữ và có óc phán đoán thông thường. Để xếp hạng tài liệu hiệu quả, nó cần cả hai yếu tố này: hiểu ngôn ngữ (ví dụ: nghĩa của các từ và cụm từ) và kiến thức về thế giới (ví dụ: các sự kiện, khái niệm thực tế). Kiến thức thế giới này được thu thập từ chính web và các mô hình ngôn ngữ lớn khác.

Ví dụ: Nếu bạn tìm “tại sao lá rụng về cội”, DeepRank không chỉ đơn thuần tìm các trang có từ “lá rụng về cội”. Nó sẽ cố gắng hiểu ý nghĩa sâu xa của câu tục ngữ này trong văn hóa Việt Nam, tức là sự nhớ về nguồn cội, quê hương.

Để làm được điều này, nó cần hiểu được cấu trúc ngôn ngữ của câu nói và có kiến thức nền tảng về văn hóa, triết lý dân gian Việt Nam, được học từ hàng tỷ văn bản trên internet.

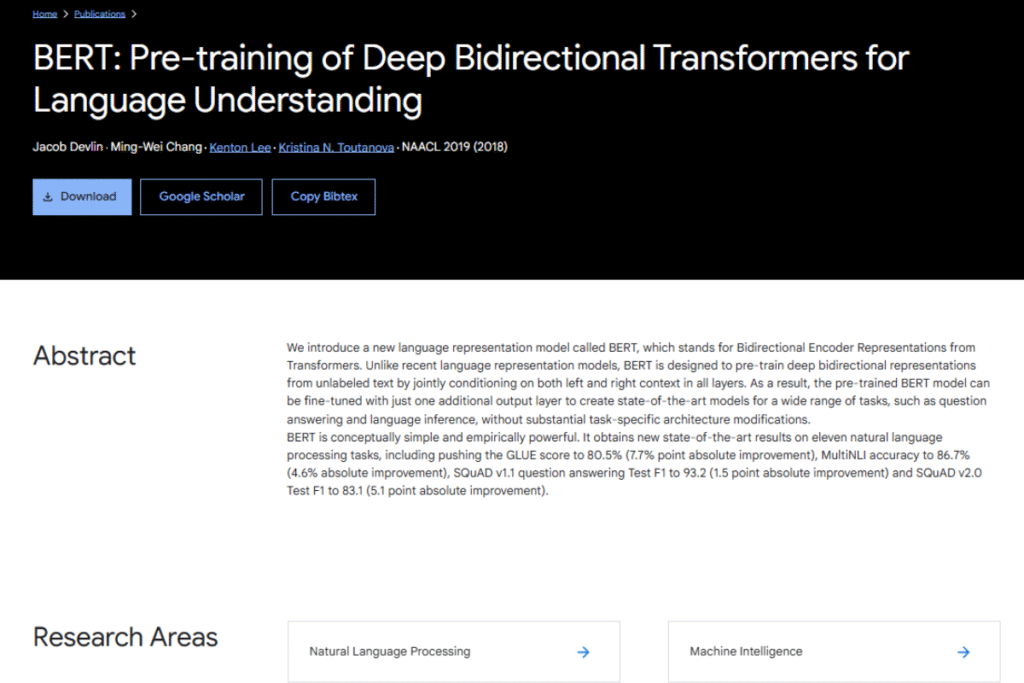

BERT (Language Understanding)

BERT là một thuật toán giúp Google xác định các tài liệu bổ sung mà các phương pháp truy xuất thông thường như chỉ dựa vào từ khóa có thể bỏ lỡ.

Cách học: BERT được huấn luyện dựa trên tài liệu, lượt nhấp chuột và dữ liệu truy vấn. Nó cũng được tinh chỉnh dựa trên dữ liệu xếp hạng IS.

Ví dụ: Giả sử bạn tìm kiếm “du lịch từ Hà Nội đến Sài Gòn nhưng đi máy bay”. Một thuật toán cũ có thể chỉ tìm các trang về “du lịch Hà Nội Sài Gòn”. Nhưng BERT sẽ hiểu rằng bạn muốn đi bằng máy bay chứ không phải phương tiện khác, và sẽ ưu tiên các kết quả về vé máy bay, hãng hàng không, sân bay,…, ngay cả khi từ “máy bay” không phải là từ khóa chính trong nhiều trang du lịch.

MUM

MUM là một mô hình học sâu rất “đắt tiền” và phức tạp. Do đó, nó không được chạy trực tiếp cho mọi truy vấn tìm kiếm. Thay vào đó, MUM được dùng để huấn luyện các mô hình nhỏ hơn bằng các phương pháp đặc biệt, và những mô hình nhỏ này mới được sử dụng để phục vụ các truy vấn trong thực tế.

QBST (Query Based Scraped Terms) và trọng số kỳ hạn

QBST (Query Based Salient Terms) và trọng số kỳ hạn là các thành phần xếp hạng khác mà Nayak, 1 chuyên gia của Google đã đề cập trong bài viết “How Google Search and ranking works, according to Google’s Pandu Nayak” của Search Engine Land.

Chúng được huấn luyện dựa trên dữ liệu xếp hạng và có thể là một loại “hệ thống ghi nhớ”, nghĩa là chúng có thể sử dụng dữ liệu truy vấn và nhấp chuột để học hỏi.

Ví dụ: Khi bạn tìm “bài hát yêu nước Việt Nam hay nhất”, QBST có thể sẽ nhận diện các từ khóa và cụm từ thường xuất hiện cùng với “bài hát yêu nước” trên các trang chất lượng cao (ví dụ: “Tiến Quân Ca”, “Tổ Quốc Gọi Tên Mình”). Nó học từ các mẫu dữ liệu này để đưa ra kết quả phù hợp hơn, dựa trên việc ghi nhớ các mối liên hệ phổ biến và hữu ích mà người dùng đã từng tương tác.

Học hỏi từ người dùng

Ngoài các hệ thống học sâu, Google còn liên tục cải thiện chất lượng tìm kiếm bằng cách học hỏi trực tiếp từ hành vi của người dùng.

Dữ liệu nhấp chuột

Google sử dụng hàng nghìn tỷ ví dụ về hành vi nhấp chuột của người dùng. Dữ liệu này cung cấp một bức tranh rõ ràng hơn rất nhiều về cách mọi người tương tác với kết quả tìm kiếm so với việc chỉ dựa vào các đánh giá thủ công của con người (IS).

Mặc dù 1 triệu đánh giá IS là hữu ích, nhưng hàng trăm tỷ lượt nhấp chuột cho phép Google học được những “hiệu ứng bậc hai và bậc ba” tinh vi hơn.

Lưu ý: Nhiều Click KHÔNG đồng nghĩa với việc bạn sẽ ranking cao trên SERP. Vì nếu chỉ tập trung vào lượt nhấp, Google có thể sẽ xếp hạng những kết quả chất lượng thấp, mang tính câu view, hoặc không liên quan.

Google cố gắng dự đoán người dùng sẽ nhấp vào kết quả nào. Đây là một vấn đề tối ưu hóa khổng lồ, sử dụng hàng trăm tỷ ví dụ về hành vi người dùng trong quá khứ để dự đoán hành vi tương lai. Đây chính là kết quả được đề xuất ở các phần Google Suggest, Google People also search for và People also Ask trên SERP.

Thuật toán Priors

Thuật toán Priors là thuật toán xếp hạng các lựa chọn dựa trên mức độ phổ biến của chúng. Nếu Google không biết gì về người dùng (ví dụ: người dùng mới tinh, không có lịch sử tìm kiếm), thì Google sẽ sử dụng thuật toán Priors để trả về kết quả cho người dùng.

Thuật toán Priors cũng có thể cá nhân hóa kết quả dựa trên các hành động trước đây của người dùng, nhưng không sử dụng thông tin nhân khẩu học (tuổi, giới tính, v.v.)

Bạn có thể xem qua bản tài liệu mà Google chia sẻ về thuật toán Priors dưới đây để hiểu rõ hơn:

Ví dụ: Khi bạn tìm “quán cà phê đẹp ở Sài Gòn” mà không có lịch sử tìm kiếm nào trước đó, Google có thể sẽ hiển thị các quán cà phê nổi tiếng nhất (phổ biến nhất) dựa trên thuật toán Priors.

Nếu sau đó bạn liên tục nhấp vào các quán cà phê có phong cách vintage, thuật toán sẽ ghi nhận và có thể ưu tiên các quán tương tự trong các tìm kiếm sau, mà không cần biết bạn là ai hay bao nhiêu tuổi.

Hiệu ứng mạng dữ liệu

Đây là một khái niệm quan trọng giải thích sự phát triển liên tục của Google Tìm kiếm. Nó mô tả một vòng lặp tích cực: Chất lượng cao => nhiều người dùng hơn => nhiều phân tích hơn => chất lượng cao hơn.

Khi Google cung cấp kết quả tìm kiếm chất lượng cao (ví dụ: trả lời chính xác và nhanh chóng các câu hỏi của người dùng), họ sẽ thu hút được nhiều người dùng hơn. Lượng người dùng lớn này tạo ra một lượng dữ liệu khổng lồ về các truy vấn và hành vi tương tác (nhấp chuột).

Google sau đó phân tích dữ liệu này để hiểu rõ hơn về nhu cầu và mong muốn của người dùng, từ đó tinh chỉnh và cải thiện thuật toán của mình. Quá trình cải tiến này lại dẫn đến chất lượng tìm kiếm cao hơn nữa, thu hút thêm người dùng, và cứ thế tiếp diễn.

Kết quả hiển thị trên SERP

SERP là gì?

SERP hay Search Engine Results Page là trang hiển thị kết quả tìm kiếm. Khi bạn gõ một câu hỏi hoặc từ khóa vào ô tìm kiếm của Google và nhấn Enter, trang mà bạn nhìn thấy chứa tất cả các kết quả trả về chính là SERP.

Mục tiêu cuối cùng của Google là cung cấp cho bạn những kết quả chính xác, hữu ích và phù hợp nhất có thể trên SERP này.

Các loại tính năng trên SERP

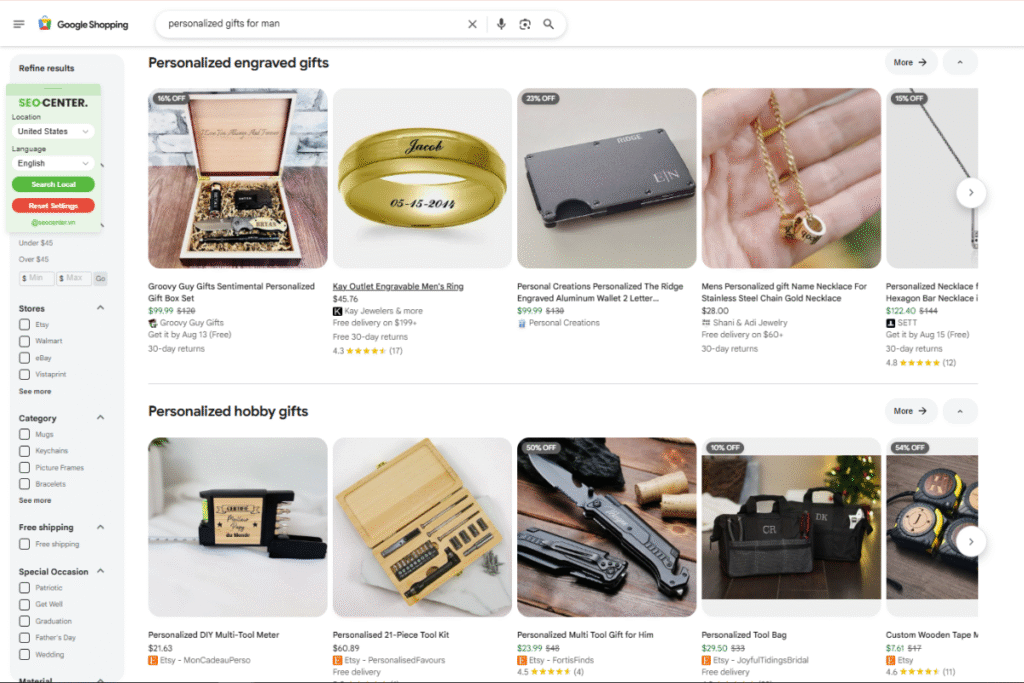

1. Sản phẩm phổ biến (Popular Products)

Đây là một danh sách các sản phẩm liên quan đến truy vấn của bạn, thường đi kèm với các thông tin quan trọng như giá cả, đánh giá của người dùng, và thông tin vận chuyển.

2. Tổ chức (Organization)

Đây là một bảng thông tin (thường xuất hiện ở bên phải hoặc trên cùng của trang) cung cấp các chi tiết cơ bản và quan trọng về một tổ chức, ví dụ như người sáng lập, lịch sử hình thành, hoặc các liên kết đến hồ sơ mạng xã hội chính thức.

3. Doanh nghiệp địa phương (Local Business)

Tính năng này tập trung vào các doanh nghiệp nằm gần vị trí của bạn (dựa trên địa lý của người tìm kiếm). Nó hiển thị các thông tin hữu ích như địa chỉ cụ thể, số điện thoại, và giờ hoạt động.

4. Câu hỏi thường gặp (FAQs)

Đây là một danh sách các câu hỏi và trả lời phổ biến nhất về một chủ đề cụ thể.

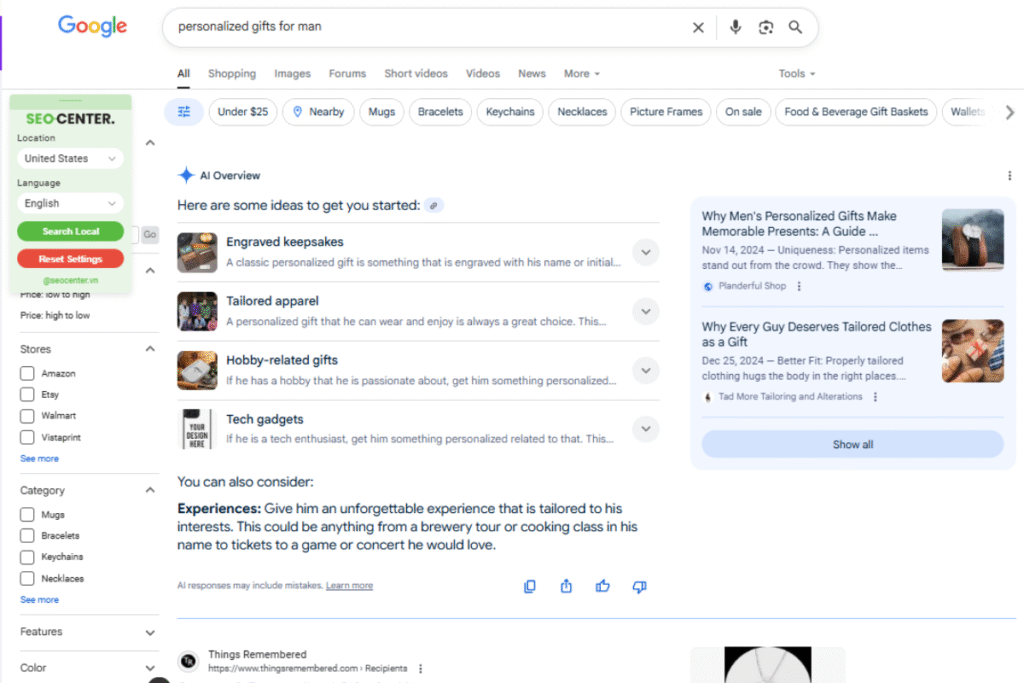

5. AI Overviews, Featured Snippets và Hộp People Also Ask – PAA

Những tính năng này thường xuất hiện cho các tìm kiếm mang tính chất thông tin (ví dụ: tìm hiểu, học hỏi). Chúng cung cấp câu trả lời nhanh chóng trực tiếp trên SERP, thường là một đoạn văn bản tóm tắt, một danh sách hoặc một bảng biểu được trích xuất từ một trang cụ thể.

6. Kết quả tìm kiếm trả phí (Paid Search Results)

Đây là các kết quả quảng cáo và chúng luôn xuất hiện ở vị trí ưu tiên, thường là đầu trang SERP.

Các website phải trả tiền cho Google thông qua nền tảng Google Ads để được hiển thị tại đây, theo một mô hình đấu giá trả tiền theo lượt nhấp (PPC – Pay-Per-Click).

Điểm đánh giá và sự cải thiện kết quả tìm kiếm của Google

Điểm IS (Information Satisfaction)

Google có một thước đo quan trọng hàng đầu về chất lượng tìm kiếm được gọi là Điểm IS hay Information Satisfaction.

Bạn có thể hình dung Điểm IS như một “phiếu chấm điểm” mà Google thu thập từ con người để biết được mức độ hài lòng của người dùng với các kết quả tìm kiếm. Nó được coi là một “xấp xỉ mức độ hữu ích của người dùng”.

Điểm IS luôn luôn là thước đo của con người. Cũng theo Pandu Nayak chia sẻ với Search Engine Land, Google không tự động tính toán điểm này mà dựa vào một đội ngũ lớn gồm 16.000 người thử nghiệm trên toàn thế giới.

Những người này, được gọi là “người đánh giá chất lượng tìm kiếm” (search quality raters), sẽ xem xét các mẫu kết quả tìm kiếm và đưa ra phản hồi về sự liên quan và độ tin cậy của thông tin.

Google sử dụng các hướng dẫn đánh giá chất lượng tìm kiếm (Search Quality Evaluator Guidelines) để đảm bảo các đánh giá này nhất quán.

Bạn hãy xem qua video “How Google Search Works (in 5 minutes)” sau đây của Google để hiểu rõ hơn nhé:

Điểm IS được sử dụng như thế nào?

- Huấn luyện các mô hình học sâu: Điểm IS là dữ liệu quý giá để huấn luyện các hệ thống học sâu (deep learning models) của Google. Ví dụ, các mô hình như RankBrain, DeepRank và BERT đều được tinh chỉnh dựa trên dữ liệu đánh giá IS.

- Thử nghiệm nhanh chóng các thay đổi: Khi Google muốn thử nghiệm một thay đổi mới trong thuật toán xếp hạng, họ sẽ dùng điểm IS để đánh giá “nhanh chóng” xem thay đổi đó có cải thiện kết quả hay không. Nếu một thay đổi không mang lại kết quả tốt, nó sẽ không được triển khai rộng rãi.

- Xác định các truy vấn cần cải thiện: Google thường xuyên xem xét các truy vấn có điểm IS thấp để tìm cảm hứng cải thiện thuật toán. Điều này giúp họ hiểu được vấn đề đang xảy ra và những gì họ đang bỏ lỡ.

Các số liệu đánh giá chất lượng tìm kiếm khác của Google

Ngoài Điểm IS, Google Search Quality còn sử dụng bốn số liệu chính khác để nắm bắt ý định người dùng và đánh giá chất lượng tìm kiếm, gồm:

- PQ (Page Quality – Chất lượng trang): Đánh giá chất lượng tổng thể của trang web.

- Juxtaposition (Sự đối chiếu): So sánh các kết quả cạnh nhau.

- Live Experiments (Thử nghiệm trực tiếp): Chạy các thử nghiệm trực tiếp trên một phần nhỏ người dùng để đo lường hành vi thực tế, ví dụ như vị trí các lượt nhấp chuột dài có trọng số.

- Freshness (Độ tươi mới): Đảm bảo rằng các tín hiệu xếp hạng phản ánh tình trạng hiện tại của thế giới, đặc biệt quan trọng với các truy vấn về tin tức.

Học hỏi từ dữ liệu người dùng

Nếu Điểm IS là “bức tranh độ phân giải thấp”, thì dữ liệu nhấp chuột (click data) cung cấp một bức tranh rõ ràng hơn rất nhiều về cách mọi người tương tác với kết quả tìm kiếm.

Google còn sẽ sử dụng đến các hành vi tìm kiếm và trải nghiệm trên các website được mình giới thiệu ở trên để cải thiện kết quả tìm kiếm trên SERP nữa.

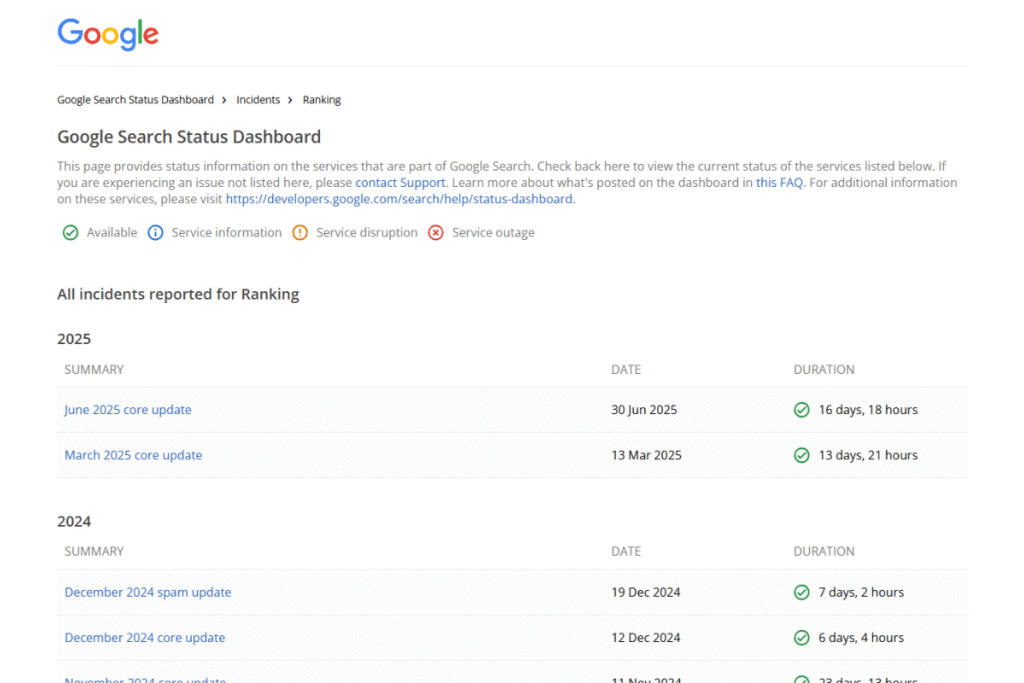

VI. Cập nhật thuật toán của Google – Không ngừng phát triển

Google thực hiện hàng nghìn bản cập nhật mỗi năm. Có những bản cập nhật nhỏ hàng ngày và những bản cập nhật lớn hơn, được gọi là “Core Updates”.

Các bản cập nhật quan trọng trong quá khứ:

- Spam Update (Tháng 3/2024): Tăng cường khả năng phát hiện các hành vi spam như lạm dụng tên miền hết hạn, xuất bản nội dung chất lượng thấp hàng loạt.

- Helpful Content Update (Tháng 8/2022): Thưởng cho các nội dung hữu ích, đặt người dùng lên hàng đầu.

- BERT Update (Tháng 10/2019): Cải thiện khả năng hiểu ngôn ngữ tự nhiên và ngữ cảnh tìm kiếm của Google.

- RankBrain Update (Tháng 10/2015): Hệ thống AI đầu tiên giúp Google hiểu tốt hơn các truy vấn mới.

- Mobile-Friendly Update (Tháng 2/2015): Biến tính thân thiện với thiết bị di động thành một yếu tố xếp hạng quan trọng.

- Penguin Update (Tháng 4/2012): Nhắm mục tiêu vào các hành vi xây dựng liên kết thao túng và nhồi nhét từ khóa.

- Panda Update (Tháng 2/2011): Nhằm giảm thứ hạng cho các trang web chất lượng thấp và thúc đẩy các trang chất lượng.

Note: Bạn có thể kiểm tra Google Search Status Dashboard hoặc Semrush Sensor để xem có bản cập nhật nào đang diễn ra không.

Kết luận

Bài viết trên được mình nghiên cứu và tổng hợp từ nhiều nguồn thông tin uy tín như Google Search Central, Ahrefs, Semrush, Search Engine Land, Search Engine Journal,….. Cùng với kiến thức hơn 7 năm làm SEO của mình. Nếu có điều gì cần giải đáp thì hãy để lại bình luận bên dưới để cùng nhau trao đổi nhé!

Nguồn bài viết tham khảo:

- https://searchengineland.com/how-google-search-ranking-works-445141

- https://searchengineland.com/how-google-search-ranking-works-pandu-nayak-435395

- https://www.reddit.com/r/explainlikeimfive/comments/shts8/eli5_how_do_modern_search_engines_like_google_work/

- https://ahrefs.com/blog/how-do-search-engines-work/

- https://www.searchenginejournal.com/search-engines/

- https://www.reddit.com/r/SEO/comments/1bcrju7/how_does_google_seo_work/

- https://www.semrush.com/blog/google-search-algorithm/

- https://developers.google.com/search/docs/fundamentals/how-search-works

- https://www.google.com/intl/en_us/search/howsearchworks/how-search-works/organizing-information/

- https://developers.google.com/search/docs/fundamentals/seo-starter-guide?hl=vi